ホーム > 畜産 > 畜産の情報 > 人工知能の画像解析を利用した肉用鶏の成育・健康管理システム開発に関する研究

国立大学法人山形大学 農学部 教授 堀口 健一

【要約】

養鶏(肉用鶏)の飼養管理において、人工知能を利用して画像情報から効率的な監視による肉用鶏の成育・健康状態を把握する管理システムの開発に必要な知見を得るため、多様な画像情報と人工知能の技術を組み合わせ、個体の検出と追跡、摂食行動と飲水行動の検出、体温(死鶏)の検出について検討した。その結果、調査対象週齢の肉用鶏では、一定の体重増加率や行動量の範囲で個体識別用の物体検出モデルを再作成することで、50%程度の精度で検出を継続することが可能であること、首の曲げ角度が異なる動作パタンの組み合わせで作成した物体検出モデルは摂食または飲水の発現行動を高い精度で検出できること、死鶏画像を用いて作成した物体検出モデルは死鶏の検出が可能であることが示唆された。

1 はじめに

畜産現場において、それぞれの飼養規模に合わせた最適な管理を適正な飼養環境下で行うことが重要となる。特に大規模化が進む中で、生産面や衛生面を最適化しながら快適性に配慮した家畜飼養、作業の負担軽減といった点を意識した管理技術の高度化が求められ、モノのインターネット(IoT)や人工知能(AI)を活用し、家畜の成育・健康状態を監視できる管理技術の導入による、効率的な飼養管理へ展開していくことが望まれている。

家畜飼養での群れ管理下において、生産効率の向上や防疫態勢の強化につながる飼養管理が不可欠であり、アニマルウェルフェア(AW)の考え方を踏まえた飼養管理にも対応していくことが必要である。これらを体系的に構築していくためには、多様なセンサデバイスから得られた情報をIoTやAIといった技術を活用しながら家畜の飼養管理の中で共有できるシステムが強く求められ、飼養管理に必要な情報に変換していくシステムを構築する技術開発が重要である。

そこで、本研究では飼養規模の拡大が著しい養鶏(肉用鶏)でのAIの利用による適切な飼養管理に関する技術開発に必要な知見を得るため、多様な画像情報とAIによる画像認識の技術を組み合わせ、それらから作成した物体検出モデルにおいて、個体の検出と追跡、行動(摂食行動、飲水行動)の検出、体温(死鶏)の検出について検討した。

家畜飼養での群れ管理下において、生産効率の向上や防疫態勢の強化につながる飼養管理が不可欠であり、アニマルウェルフェア(AW)の考え方を踏まえた飼養管理にも対応していくことが必要である。これらを体系的に構築していくためには、多様なセンサデバイスから得られた情報をIoTやAIといった技術を活用しながら家畜の飼養管理の中で共有できるシステムが強く求められ、飼養管理に必要な情報に変換していくシステムを構築する技術開発が重要である。

そこで、本研究では飼養規模の拡大が著しい養鶏(肉用鶏)でのAIの利用による適切な飼養管理に関する技術開発に必要な知見を得るため、多様な画像情報とAIによる画像認識の技術を組み合わせ、それらから作成した物体検出モデルにおいて、個体の検出と追跡、行動(摂食行動、飲水行動)の検出、体温(死鶏)の検出について検討した。

2 画像情報とAIを利用した肉用鶏における個体の検出と追跡の検討

現在、AIの開発環境はオープン化され、農業分野や畜産分野へも活用できる土台が構築されつつある。畜産分野(肉用鶏の生産現場)においては、飼養規模の拡大に伴う最適な管理システムの強化とともに、生産現場での人手不足へ対応した管理システムへの移行が求められており、少ない労働力で最大限の生産を得られる効率的な家畜(肉用鶏)の飼養管理をアシストしていく技術の開発が強く望まれている。本調査では、肉用鶏の多羽飼養での群れ管理下において、一定個体(鶏舎内の飼養総羽数のうち、数パーセントの個体)の情報から総体的な成育状態を把握するための技術開発に不可欠な個体の検出と追跡について、可視光カメラを用いて得られた画像に対する、個体識別用の物体検出モデルの検出精度や追跡能力を検証した。

雛 を導入し、群れでの一般的な飼養条件下で管理した10羽(5週齢)を供試した。本調査は山形大学動物実験委員会の承認を受けた動物実験飼養施設にて動物実験計画書に従って実施した。飼料は市販の配合飼料を、水は水道水を用いた。飼養管理については、仕切り板で囲いを設置して給餌器と給水器を配置した二つのエリアに分割し、不断給餌、自由飲水とし、敷料としてもみ殻を用いて行った。

本調査では飼養管理した10羽のうち、1羽の肉用鶏(ID95鶏)を選定して個体識別用の物体検出モデルを作成した。市販の可視光カメラ(M25、Mobotix)で収集した画像から、ID95鶏を物体検出モデルへ学習させるため、アノテーション作業(鶏体をポリゴン(多角形)頂点で囲うラベル付け作業)として、同個体の全身を指定した。アノテーションによる物体検出モデル学習用の教師データは2617枚とし、物体の特徴を学習させるためのディープラーニング(注1)のフレームワークにオープンソースのニューラルネットワークである、Darknetを、物体検出アルゴリズムにYOLOv4(yolov4.conv. 137)を用いて転移学習にて物体検出モデルを作成した。YOLOは、物体検出のアルゴリズムであり、You Only Look Onceの頭文字から作成された造語である。YOLO以外のアルゴリズムでは、物体を検出する場合、複数の要素に分類した後、どのような物体かを判断しているため検出の速度と正確さで劣っている。YOLOは、入力画像を正方形にリサイズし、ニューラルネットワークを用いて物体の特徴を高速に見つけながら細かく画像解析を行うため、高速かつ高精度な物体検出が可能である。ディープラーニングの学習の設定は、入力する画像サイズを800×800ピクセル、バッチサイズ(教師データをグループ分けした際の大きさ)を64、Train(訓練データ)とValidation(検証データ)の分割割合を8:2とし、学習回数を1万回で統一した。

肉用鶏の成長により、その容姿は変化するため、定期的に新たな画像を用いて物体検出モデルを作り変えることで、一定の調査期間での個体の検出と追跡を行った。肉用鶏の個体検出モデルは、撮影1日目の画像データ2617枚で作成したパタンAの物体検出モデル、撮影1、4、7日目に、それぞれ2617枚の画像で作成したパタンBの物体検出モデルを比較した。

(注1)ディープラーニングとは、人間の手を使わず、コンピュータが自動的に大量のデータの中から特徴を発見する機械学習技術のこと。

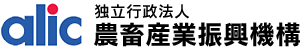

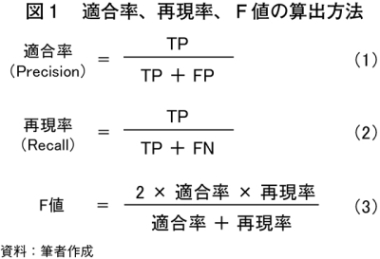

物体検出モデルがID95鶏をどの程度正確に検出・分類できるか調査するため、本実験では適合率と再現率、F値を算出して評価した。本実験の場合、適合率は物体検出モデルが検出したすべてのID95鶏のうち、正確に分類できた割合を示す指標である。適合率は、1に近いほど、物体検出モデルが誤分類していないことを示す。再現率は、物体検出モデルが検出・分類対象のID95鶏を正確に検出・分類した割合を示す指標である。再現率は、1に近いほど物体検出モデルが検出対象のID95鶏を見逃していないことを示す。F値は、適合率と再現率の調和平均である。F値は、1に近いほど、物体検出モデルがID95鶏を未検出・誤分類することが少ないことを示す。これらの指標は、図1の式(1)〜(3)に基づき算出した。

TP(True Positive:真陽性)は、物体検出モデルがテスト画像内のID95鶏を正確に検出・分類できたケースである。FP(False Positive:偽陽性)は、物体検出モデルが検出したID95鶏の分類項目を誤分類したケースである。FN(False Negative:偽陰性)は、物体検出モデルが検出対象のID95鶏を見逃したケースである。精度評価者は、物体検出モデルがテスト画像内のID95鶏をどのように検出・分類したか確認し、TPとFP、FNのいずれに該当するか確認した。それらの個数を式(1)〜(3)に代入することで、分類項目ごとの適合率と再現率、F値を算出した。

物体検出モデルの精度評価は、作成したパタンAとBの二つのID95鶏を検出する物体検出モデルに対して、モデル作成用と異なるテスト用画像を撮影期間中の12:00〜13:00の時間帯から1日当たり100枚(20枚×5セット)を無作為に抽出し、合計900枚で混同行列に従って行った。適合率などはDarknetに実装されている「. /darknet detector map」プログラムを利用して算出し、信頼度(物体検出モデルが検出したものが対象物であると推定した確率)が50%以上のものを検出するように指定した。

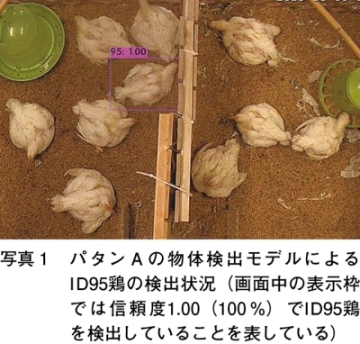

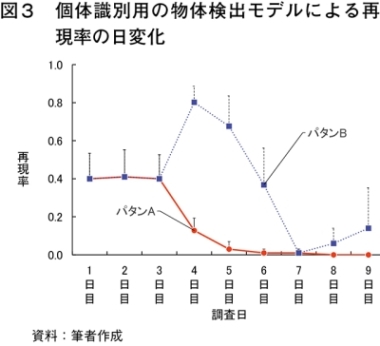

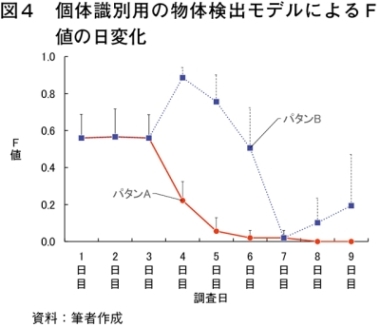

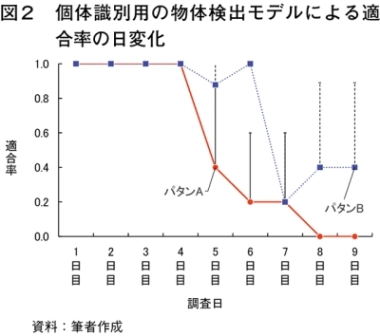

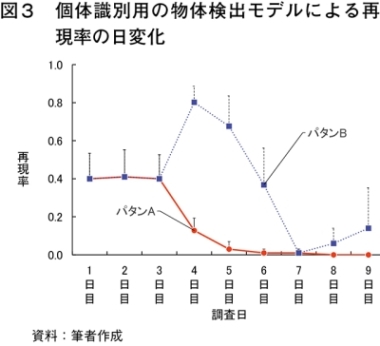

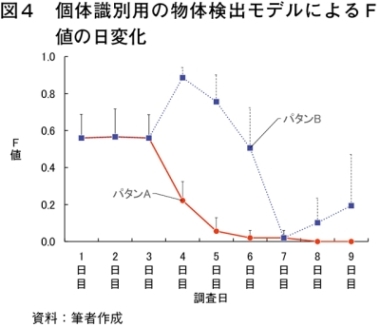

作成した個体識別用の物体検出モデルの精度を判断するための適合率、再現率およびF値の結果を図2〜4に示した。適合率において、パタンAは調査4日目まで良好であったが、その後、時間の経過とともに低下し、パタンBは調査6日目まで0.8〜1.0と良好であり、それ以降で低下した。再現率を見ると、両パタンとも調査3日目まで0.4程度であり、ID95鶏の誤検出や未検出があったが、パタンBは調査4日目に検出能力が0.8まで改善され、パタンAと明らかに傾向が異なっていた。F値に関して、両パタンとも調査3日目まで同様に推移し、パタンBは調査4日目で高まり、調査4日目以降でパタンAとパタンBの変化は大きく異なっていた。

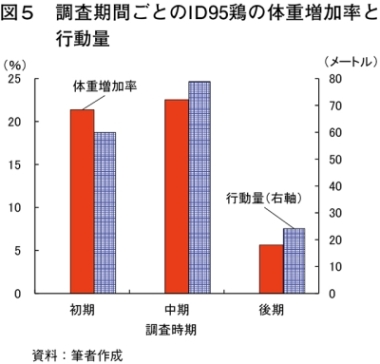

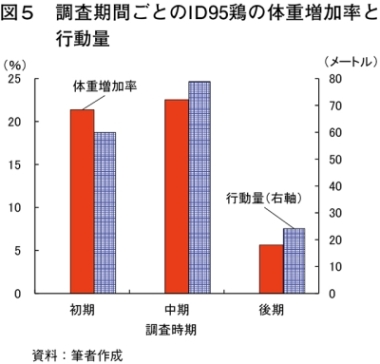

図5には調査初期から後期までの体重増加率と行動量を示した。これらの結果と比較させながら物体検出モデルの検出精度を照らし合わせると、調査初中期は、ID95鶏の行動量が多く、体重の増加に伴う体型や羽毛といった容姿の変化により、特徴点となり得る多様な画像を収集できていたことが考えられる。これらの画像を使って作成した新たな物体検出モデルを調査4日目に差し替えることで、新たな容姿に追従できる物体検出モデルとなり、ID95鶏をある程度の精度で検出できたと考えられる。一方、調査7日目からの調査後期において、新たに作成したパタンBの物体検出モデルは、調査1、4、7日目に収集した画像で作成しており、調査4〜6日目の期間での行動量とともに、体重の増加に伴う特徴点の変化が大きく、物体検出モデルが対応しきれていなかったと思われ、調査7日目時点では再現率が上昇すると期待していた。しかしながら、AI作成のために収集したID95鶏の画像の多くが動きの乏しいシーンであったことが影響し、作成した物体検出モデルでは実際の鶏の成長に伴う容姿の変化に追従できず、ID95鶏の検出が難しかったのではないかと考えられる。

これらの結果から、調査対象とした5〜6週齢の肉用鶏では、一定の体重増加率や行動量の範囲で個体識別用の物体検出モデルを再作成することで、50%程度の精度で検出を継続することが可能であることが示唆された。なお、5週齢の後半では、適合率、再現率、F値がともに低下していることから、体重増加率や行動量を加味して物体検出モデルを切り替える必要があると思われる。

(1)材料と方法

ア 供試動物と飼養条件

肉用鶏(チャンキーブロイラー、雌)のイ データの収集と物体検出モデルの作成

画像データは、5〜6週齢の肉用鶏を撮影した画像を用いた。また、無線で自動認識が可能な個体識別用の小型タグ(RFIDタグ)を肉用鶏に取り付け、二つのエリアの通路にRFIDタグ受信器内蔵の体重計を設置し、個体の確認と体重を記録した。本調査では飼養管理した10羽のうち、1羽の肉用鶏(ID95鶏)を選定して個体識別用の物体検出モデルを作成した。市販の可視光カメラ(M25、Mobotix)で収集した画像から、ID95鶏を物体検出モデルへ学習させるため、アノテーション作業(鶏体をポリゴン(多角形)頂点で囲うラベル付け作業)として、同個体の全身を指定した。アノテーションによる物体検出モデル学習用の教師データは2617枚とし、物体の特徴を学習させるためのディープラーニング(注1)のフレームワークにオープンソースのニューラルネットワークである、Darknetを、物体検出アルゴリズムにYOLOv4(yolov4.conv. 137)を用いて転移学習にて物体検出モデルを作成した。YOLOは、物体検出のアルゴリズムであり、You Only Look Onceの頭文字から作成された造語である。YOLO以外のアルゴリズムでは、物体を検出する場合、複数の要素に分類した後、どのような物体かを判断しているため検出の速度と正確さで劣っている。YOLOは、入力画像を正方形にリサイズし、ニューラルネットワークを用いて物体の特徴を高速に見つけながら細かく画像解析を行うため、高速かつ高精度な物体検出が可能である。ディープラーニングの学習の設定は、入力する画像サイズを800×800ピクセル、バッチサイズ(教師データをグループ分けした際の大きさ)を64、Train(訓練データ)とValidation(検証データ)の分割割合を8:2とし、学習回数を1万回で統一した。

肉用鶏の成長により、その容姿は変化するため、定期的に新たな画像を用いて物体検出モデルを作り変えることで、一定の調査期間での個体の検出と追跡を行った。肉用鶏の個体検出モデルは、撮影1日目の画像データ2617枚で作成したパタンAの物体検出モデル、撮影1、4、7日目に、それぞれ2617枚の画像で作成したパタンBの物体検出モデルを比較した。

(注1)ディープラーニングとは、人間の手を使わず、コンピュータが自動的に大量のデータの中から特徴を発見する機械学習技術のこと。

ウ 物体検出モデルの精度評価

物体検出モデルがID95鶏をどの程度正確に検出・分類できるか調査するため、本実験では適合率と再現率、F値を算出して評価した。本実験の場合、適合率は物体検出モデルが検出したすべてのID95鶏のうち、正確に分類できた割合を示す指標である。適合率は、1に近いほど、物体検出モデルが誤分類していないことを示す。再現率は、物体検出モデルが検出・分類対象のID95鶏を正確に検出・分類した割合を示す指標である。再現率は、1に近いほど物体検出モデルが検出対象のID95鶏を見逃していないことを示す。F値は、適合率と再現率の調和平均である。F値は、1に近いほど、物体検出モデルがID95鶏を未検出・誤分類することが少ないことを示す。これらの指標は、図1の式(1)〜(3)に基づき算出した。TP(True Positive:真陽性)は、物体検出モデルがテスト画像内のID95鶏を正確に検出・分類できたケースである。FP(False Positive:偽陽性)は、物体検出モデルが検出したID95鶏の分類項目を誤分類したケースである。FN(False Negative:偽陰性)は、物体検出モデルが検出対象のID95鶏を見逃したケースである。精度評価者は、物体検出モデルがテスト画像内のID95鶏をどのように検出・分類したか確認し、TPとFP、FNのいずれに該当するか確認した。それらの個数を式(1)〜(3)に代入することで、分類項目ごとの適合率と再現率、F値を算出した。

物体検出モデルの精度評価は、作成したパタンAとBの二つのID95鶏を検出する物体検出モデルに対して、モデル作成用と異なるテスト用画像を撮影期間中の12:00〜13:00の時間帯から1日当たり100枚(20枚×5セット)を無作為に抽出し、合計900枚で混同行列に従って行った。適合率などはDarknetに実装されている「. /darknet detector map」プログラムを利用して算出し、信頼度(物体検出モデルが検出したものが対象物であると推定した確率)が50%以上のものを検出するように指定した。

エ 調査個体の体重増加率と行動量

ID95鶏の体重はRFID受信機内蔵体重計で記録した。体重増加率は、基準値を調査初期が撮影1日目、調査中期が撮影4日目、調査後期が撮影7日目として体重増加分の差分を算出して容姿の変化を示す指標とした。また、ID95鶏の行動量は、アノテーションの際に作成した囲い線の左上部点を原点とし、XとYの座標データが得られるため、それを利用して累積値として算出し、体重を表示するLED表示器の寸法(15センチメートル×5センチメートル)と比較して距離に換算した。なお、調査期間については、1〜3日目を調査初期、4〜6日目を調査中期、7〜9日目を調査後期とした。(2)結果と考察

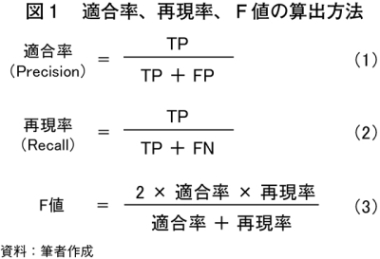

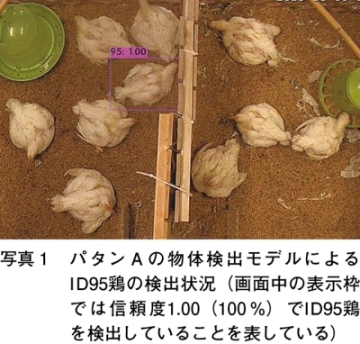

写真1にはパタンAの物体検出モデルでのID95鶏の検出状況を示した。作成した個体識別用の物体検出モデルは、調査開始日の時点で、ID95鶏を再現率0.4で検出していた。ID95鶏の体重増加率は、調査中期から調査後期の期間で39.0%、調査後期の期間で13.4%とそれぞれ増加し、成育が進むにつれて期間内の体重増加率が低下する傾向にあった。ID95鶏の体重は調査1日目で1864グラム、調査9日目で3206グラムと、期間中に体重が1342グラム増えており、体重増加率の変化と合わせて検出の特徴点となる体型や羽毛が成長して容姿が変化していたと思われる。これは、特徴に関する情報が成育に伴って変動することを示し、物体検出モデルの検出精度に影響を及ぼす。

作成した個体識別用の物体検出モデルの精度を判断するための適合率、再現率およびF値の結果を図2〜4に示した。適合率において、パタンAは調査4日目まで良好であったが、その後、時間の経過とともに低下し、パタンBは調査6日目まで0.8〜1.0と良好であり、それ以降で低下した。再現率を見ると、両パタンとも調査3日目まで0.4程度であり、ID95鶏の誤検出や未検出があったが、パタンBは調査4日目に検出能力が0.8まで改善され、パタンAと明らかに傾向が異なっていた。F値に関して、両パタンとも調査3日目まで同様に推移し、パタンBは調査4日目で高まり、調査4日目以降でパタンAとパタンBの変化は大きく異なっていた。

図5には調査初期から後期までの体重増加率と行動量を示した。これらの結果と比較させながら物体検出モデルの検出精度を照らし合わせると、調査初中期は、ID95鶏の行動量が多く、体重の増加に伴う体型や羽毛といった容姿の変化により、特徴点となり得る多様な画像を収集できていたことが考えられる。これらの画像を使って作成した新たな物体検出モデルを調査4日目に差し替えることで、新たな容姿に追従できる物体検出モデルとなり、ID95鶏をある程度の精度で検出できたと考えられる。一方、調査7日目からの調査後期において、新たに作成したパタンBの物体検出モデルは、調査1、4、7日目に収集した画像で作成しており、調査4〜6日目の期間での行動量とともに、体重の増加に伴う特徴点の変化が大きく、物体検出モデルが対応しきれていなかったと思われ、調査7日目時点では再現率が上昇すると期待していた。しかしながら、AI作成のために収集したID95鶏の画像の多くが動きの乏しいシーンであったことが影響し、作成した物体検出モデルでは実際の鶏の成長に伴う容姿の変化に追従できず、ID95鶏の検出が難しかったのではないかと考えられる。

これらの結果から、調査対象とした5〜6週齢の肉用鶏では、一定の体重増加率や行動量の範囲で個体識別用の物体検出モデルを再作成することで、50%程度の精度で検出を継続することが可能であることが示唆された。なお、5週齢の後半では、適合率、再現率、F値がともに低下していることから、体重増加率や行動量を加味して物体検出モデルを切り替える必要があると思われる。

3 画像情報とAIを利用した肉用鶏における行動検出の検討

家畜の飼養管理において、管理者による家畜の体調や成長の把握は重要であり、AWの観点から、家畜の快適性への配慮が重要視されている。肉用鶏においても、さまざまな飼養環境下での発現行動や発育性などを総合的に解析する技術開発が求められている。肉用鶏で観察されるさまざまな行動を通じて、その健康状態や成育状態を把握することが可能である。通常の飼養管理の中で発現する肉用鶏の行動のうち、生命維持や体温調整に関わる摂取行動(摂食行動と飲水行動)は極めて重要かつ基本的な行動である。本調査では、肉用鶏の摂食行動と飲水行動をAIによる画像認識から検出できるかを検証した。

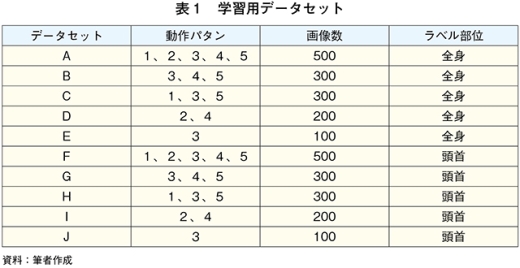

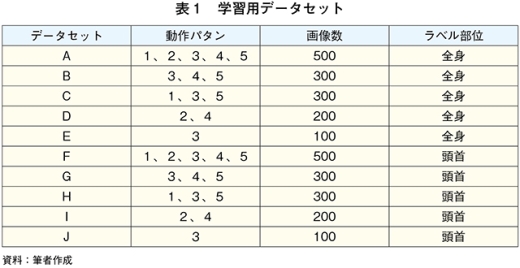

それぞれの動作パタンは以下の通りとし、学習用データセットは動作パタンの組み合わせとラベル部位の違いにより設定した(表1)。

動作パタン1 首の曲げ角度が右斜め45度以下の範囲で摂取している動作

動作パタン2 首の曲げ角度が真っすぐから右斜め45度までの範囲で摂取している動作

動作パタン3 首を真っすぐにして摂取している動作

動作パタン4 首の曲げ角度が真っすぐから左斜め45度までの範囲で摂取している動作

動作パタン5 首の曲げ角度が左斜め45度以下の範囲で摂取している動作

conv.137)を使用した。ディープラーニングの学習の設定は、入力する画像サイズを608×608ピクセル、バッチサイズを16、TrainとValidationの分割割合を8:2とし、学習回数は5000回と2万回の2種類を設定した。

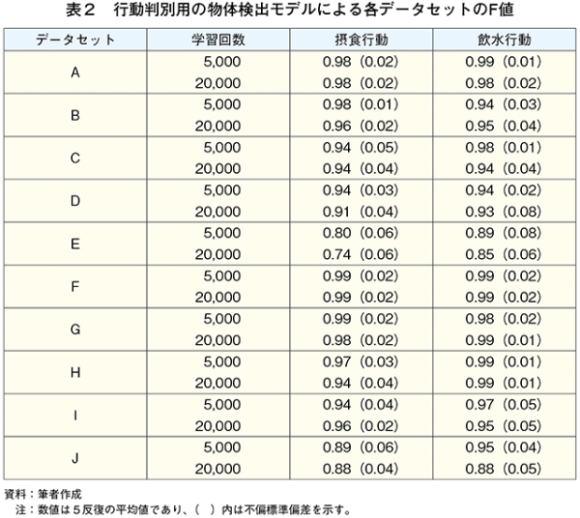

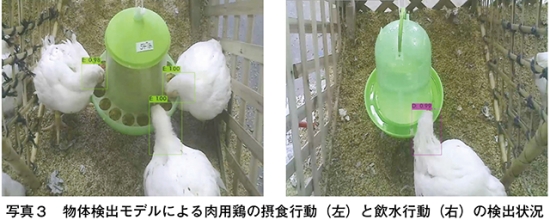

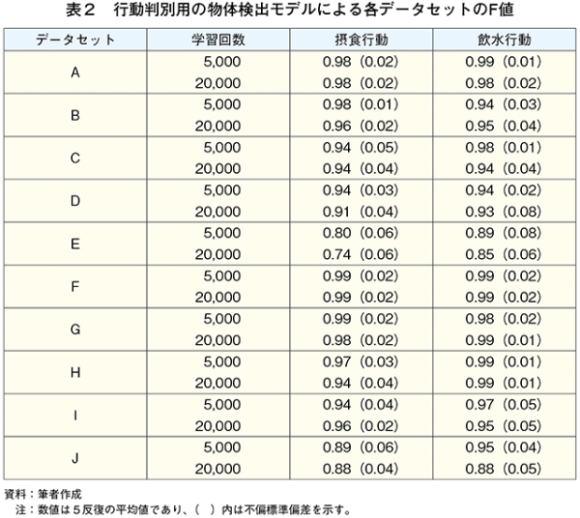

作成した物体検出モデルの検出精度の指標となるF値を表2に示した。動作パタンを二つ以上組み合わせたデータセットは、摂食行動、飲水行動とも0.9以上であり、検出精度が高かった。一方、一つの動作パタン(動作パタン3)のみとしたデータセットのEとJは、ほぼ0.9以下であった。ラベル部位による違いを組み合わせた動作パタンが同じデータセットで比較すると、摂食行動、飲水行動とも全身より頭首の方が上回った。学習回数は、2万回と比較して5000回が同等以上であった。

このことから、複数の動作パタンの画像を組み合わせ、ラベル部位を頭首とした画像を用い、学習回数を5000回として作成した物体検出モデルは、摂食行動と飲水行動を検出する精度が高くなることが確認でき、肉用鶏における摂食または飲水の発現行動を高い精度で検出可能な物体検出モデルを作成できることが示唆された。肉用鶏の首の曲げ状態を画像の特徴点とした場合(首の曲げ角度が異なる動作パタンでの検討において)、単独の動作パタンより複数の動作パタンの組み合わせ(動作パタンの多様性)が重要であると考えられ、今後の検討としては、行動判別用の物体検出モデルを作成する際の学習用の画像数による影響も踏まえ、その精度を確認していくことが必要である。

(1)材料と方法

ア 供試動物と飼養条件

肉用鶏(チャンキーブロイラー)の雌10羽(6週齢)を供試した。雛を導入後、山形大学動物実験委員会の承認を受けた動物実験飼養施設にて慣行的な飼養方法に基づいて管理した。飼料は市販の配合飼料(必要な栄養成分やミネラル成分を満たしている飼料)を、水は水道水を用い、飼料と水は自由に摂取できるようにした。肉用鶏の飼養スペースを三つに仕切り(各スペースには自由に移動できるよう一部を仕切り)、左右のスペースに給餌器または給水器を置き、もみ殻を敷料とした(写真2)。

イ 動作パタンと学習用データセット

行動は監視カメラ(CS−W72FHD、プラネックスコミュニケーションズ)を設置して動画を撮影し、発現した行動の画像を収集した。その撮影動画から摂食行動と飲水行動の画像を得た。本調査では肉用鶏が摂食行動または飲水行動しているときの首の曲げ状態を画像での特徴点の一つとして想定し、肉用鶏の体に対して首の真っ直ぐな状態からの曲げ角度により、動作を五つのパタンに分けた。それぞれの動作パタンは以下の通りとし、学習用データセットは動作パタンの組み合わせとラベル部位の違いにより設定した(表1)。

動作パタン1 首の曲げ角度が右斜め45度以下の範囲で摂取している動作

動作パタン2 首の曲げ角度が真っすぐから右斜め45度までの範囲で摂取している動作

動作パタン3 首を真っすぐにして摂取している動作

動作パタン4 首の曲げ角度が真っすぐから左斜め45度までの範囲で摂取している動作

動作パタン5 首の曲げ角度が左斜め45度以下の範囲で摂取している動作

ウ 物体検出モデルの作成

各動作パタンの学習用画像は50枚を用いた。学習用画像はすべて1羽のみの肉用鶏の画像とした。ディープラーニングを行うためにフレームワークとアルゴリズムとしてDarknetとYOLOv4(yolov4.conv.137)を使用した。ディープラーニングの学習の設定は、入力する画像サイズを608×608ピクセル、バッチサイズを16、TrainとValidationの分割割合を8:2とし、学習回数は5000回と2万回の2種類を設定した。

エ 物体検出モデルの精度評価

本実験の精度評価は、適合率と再現率、F値の3指標を算出して行った。テスト用データセットについては、摂食行動、飲水行動ともすべての動作パタンの画像を、それぞれの動作パタンとも4枚として計20枚とした。行動判別用の物体検出モデルの精度評価については、各テスト用データセットを5反復用意して5回実施し、Darknetに実装されている「. /darknet detector map」プログラムを利用し、信頼度が50%以上のものを検出するように指定して適合率、再現率、F値を算出して行った。(2)結果と考察

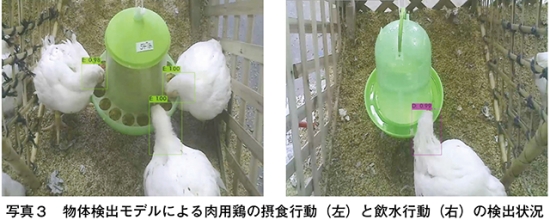

作成した行動判別用の物体検出モデルによる肉用鶏の摂食行動と飲水行動の検出状況(ラベル部位が頭首の場合)を写真3に示した。摂食行動または飲水行動を検出するために作成した物体検出モデルは、摂食行動または飲水行動が発現していた肉用鶏を検出した。作成した物体検出モデルの検出精度の指標となるF値を表2に示した。動作パタンを二つ以上組み合わせたデータセットは、摂食行動、飲水行動とも0.9以上であり、検出精度が高かった。一方、一つの動作パタン(動作パタン3)のみとしたデータセットのEとJは、ほぼ0.9以下であった。ラベル部位による違いを組み合わせた動作パタンが同じデータセットで比較すると、摂食行動、飲水行動とも全身より頭首の方が上回った。学習回数は、2万回と比較して5000回が同等以上であった。

このことから、複数の動作パタンの画像を組み合わせ、ラベル部位を頭首とした画像を用い、学習回数を5000回として作成した物体検出モデルは、摂食行動と飲水行動を検出する精度が高くなることが確認でき、肉用鶏における摂食または飲水の発現行動を高い精度で検出可能な物体検出モデルを作成できることが示唆された。肉用鶏の首の曲げ状態を画像の特徴点とした場合(首の曲げ角度が異なる動作パタンでの検討において)、単独の動作パタンより複数の動作パタンの組み合わせ(動作パタンの多様性)が重要であると考えられ、今後の検討としては、行動判別用の物体検出モデルを作成する際の学習用の画像数による影響も踏まえ、その精度を確認していくことが必要である。

4 画像情報とAIを利用した肉用鶏の体温判別(死鶏検出)の検討

畜産の生産現場では人手不足が深刻な状況になりつつあり、少ない人員での飼養管理を可能にするシステム開発が求められている。また、家畜の飼養管理において、ヒトを介さずして家畜の健康状態や成育状態といった特徴的な生体情報を取得・利用しながら作業負担の軽減となる管理システムの開発が望まれている。養鶏(肉用鶏)の大規模飼養では効率的な作業による管理技術が不可欠であり、ヒトの鶏舎への出入りを減らして衛生的な飼養環境の整備を強化することが防疫の観点からも必要である。本調査では、AIの画像認識を活用した体温(死鶏)の検出について、可視光カメラとサーマルカメラで得られた肉用鶏の死鶏画像を用いて死鶏判別用の物体検出モデルを作成して検証した。

死鶏判別用の物体検出モデルへ学習させるためのアノテーション作業は死鶏の全身を指定して行った。学習用データとしての画像は100枚とし、すべて1羽のみの死鶏の画像を用いた。死鶏判別用の物体検出モデルの作成は、ディープラーニングのフレームワークとしてDarknet、物体検出アルゴリズムとしてYOLOv4(yolov4.conv.137)を使用して行った。ディープラーニングの学習の設定は、入力する画像サイズを608×608ピクセル、バッチサイズを16、TrainとValidationの分割割合を8:2、学習回数を1万回とした。

物体検出モデルの精度判断に用いられる適合率、再現率およびF値は、それぞれ1.00であった。本調査で作成した死鶏判別用の物体検出モデルについては、その検出精度の評価を反復して実施しておらず、検出精度の再評価が必要であると考えているが、本結果を踏まえ、肉用鶏での死鶏画像を用いて作成した物体検出モデルは死鶏の検出が可能であると思われる。

(1)材料と方法

ア 供試動物

死鶏は死んだ成鶏(チャンキーブロイラー)を県内の養鶏農家から導入した。死鶏の導入や取り扱いに当たっては、県内の家畜保健衛生所の獣医師より、導入時や撮影時の詳細な留意点、具体的な対応方法を事前に確認して取り組んだ。イ 画像データの収集と物体検出モデルの作成

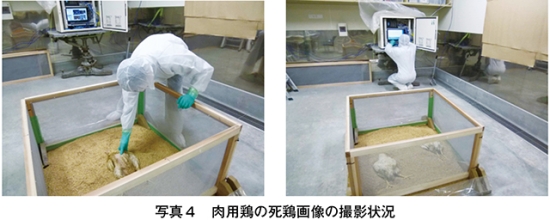

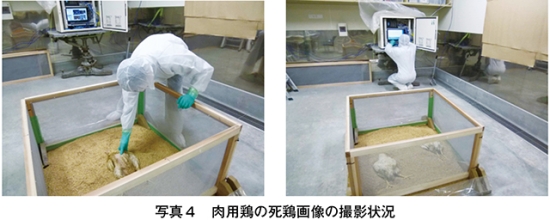

学習用とテスト用の画像データは、導入した死鶏(33日齢)各1羽を用いて撮影して準備した。導入時の死鶏の体重は、学習用が1288グラム、テスト用が1108グラムであった。画像の撮影は、市販の可視光カメラ(M25、Mobotix)とサーマルカメラ(Thermal M16、Mobotix)を用い、木製の枠で囲いを設置してもみ殻を敷いた上に死鶏を置いて行った。その際、死鶏を置く位置は木製の枠内でランダムに4カ所とし、その向きは頭が上下左右の四つの方向となるようにした(写真4)。

死鶏判別用の物体検出モデルへ学習させるためのアノテーション作業は死鶏の全身を指定して行った。学習用データとしての画像は100枚とし、すべて1羽のみの死鶏の画像を用いた。死鶏判別用の物体検出モデルの作成は、ディープラーニングのフレームワークとしてDarknet、物体検出アルゴリズムとしてYOLOv4(yolov4.conv.137)を使用して行った。ディープラーニングの学習の設定は、入力する画像サイズを608×608ピクセル、バッチサイズを16、TrainとValidationの分割割合を8:2、学習回数を1万回とした。

ウ 物体検出モデルの精度評価

本実験の精度評価は、適合率と再現率、F値の3指標を算出して行った。テスト用画像は20枚用意し、それらを作成した死鶏判別用の物体検出モデルへ入力して精度評価を行った。精度評価は、Darknetに実装されている「. /darknet detector map」プログラムを利用し、信頼度が50%以上のものを検出するように指定して適合率、再現率、F値を算出して行った。(2)結果と考察

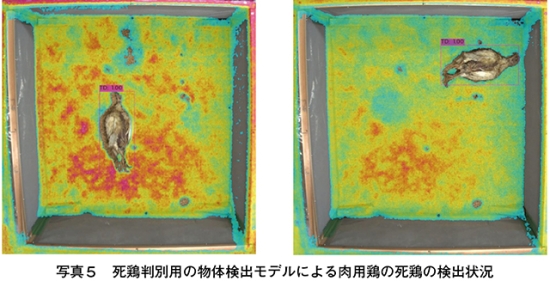

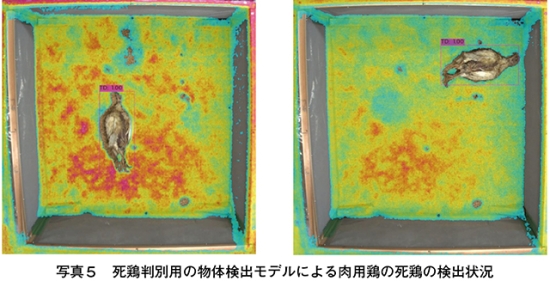

サーマルカメラで得られた肉用鶏の死鶏画像を用いて作成した物体検出モデルによる死鶏の検出状況を写真5に示した。死鶏を検出するために作成した物体検出モデルは死鶏を検出した。物体検出モデルの精度判断に用いられる適合率、再現率およびF値は、それぞれ1.00であった。本調査で作成した死鶏判別用の物体検出モデルについては、その検出精度の評価を反復して実施しておらず、検出精度の再評価が必要であると考えているが、本結果を踏まえ、肉用鶏での死鶏画像を用いて作成した物体検出モデルは死鶏の検出が可能であると思われる。

5 おわりに

今後の畜産現場ではIoTやAIの技術を適用することにより、ヒトの介在を極力減らし、ソフトウェア技術やロボット技術を用いた家畜の飼養管理をアシストする技術開発が進み、ヒトを介さずして家畜の成育・健康状態や快適性を見極めることが可能になると思われる。

本研究はAIによる画像認識の最新技術を畜産業(養鶏)へ実装していくための技術開発を目指しており、得られた成果は、国内外の養鶏における最適な飼養管理のシステム化に適用可能であり、AWに対応した飼養管理の開発にも寄与でき、管理作業時の労働負担の軽減と作業効率の改善につながる技術開発に貢献できると考えている。

畜産現場へのIoTやAIの活用は、ヒトの目でしか判別できなかった家畜の成育状態や健康状態、飼養管理における最適な作業や作業負担の軽減につながる技術ポイントについて、コンピュータを目や脳として適切に判断できるようになると考えられ、本研究から得られた成果も踏まえながら畜産現場(養鶏の生産現場)が求める次世代の飼養管理システム開発へ展開していくことが必要である。

本研究はAIによる画像認識の最新技術を畜産業(養鶏)へ実装していくための技術開発を目指しており、得られた成果は、国内外の養鶏における最適な飼養管理のシステム化に適用可能であり、AWに対応した飼養管理の開発にも寄与でき、管理作業時の労働負担の軽減と作業効率の改善につながる技術開発に貢献できると考えている。

畜産現場へのIoTやAIの活用は、ヒトの目でしか判別できなかった家畜の成育状態や健康状態、飼養管理における最適な作業や作業負担の軽減につながる技術ポイントについて、コンピュータを目や脳として適切に判断できるようになると考えられ、本研究から得られた成果も踏まえながら畜産現場(養鶏の生産現場)が求める次世代の飼養管理システム開発へ展開していくことが必要である。